25.神经网络

约 484 字大约 2 分钟

2025-09-20

神经网络的思想和核心原理

数形结合思想.

神经元模型

x1(w1),x2(w2),...xn(wn) -> f -> y

y=f(i=1∑nwixi+b)

其中f为激活函数.通常写为矩阵形式y=f(wx+b)

本质上是很多逻辑回归的线性模型模块化组合.

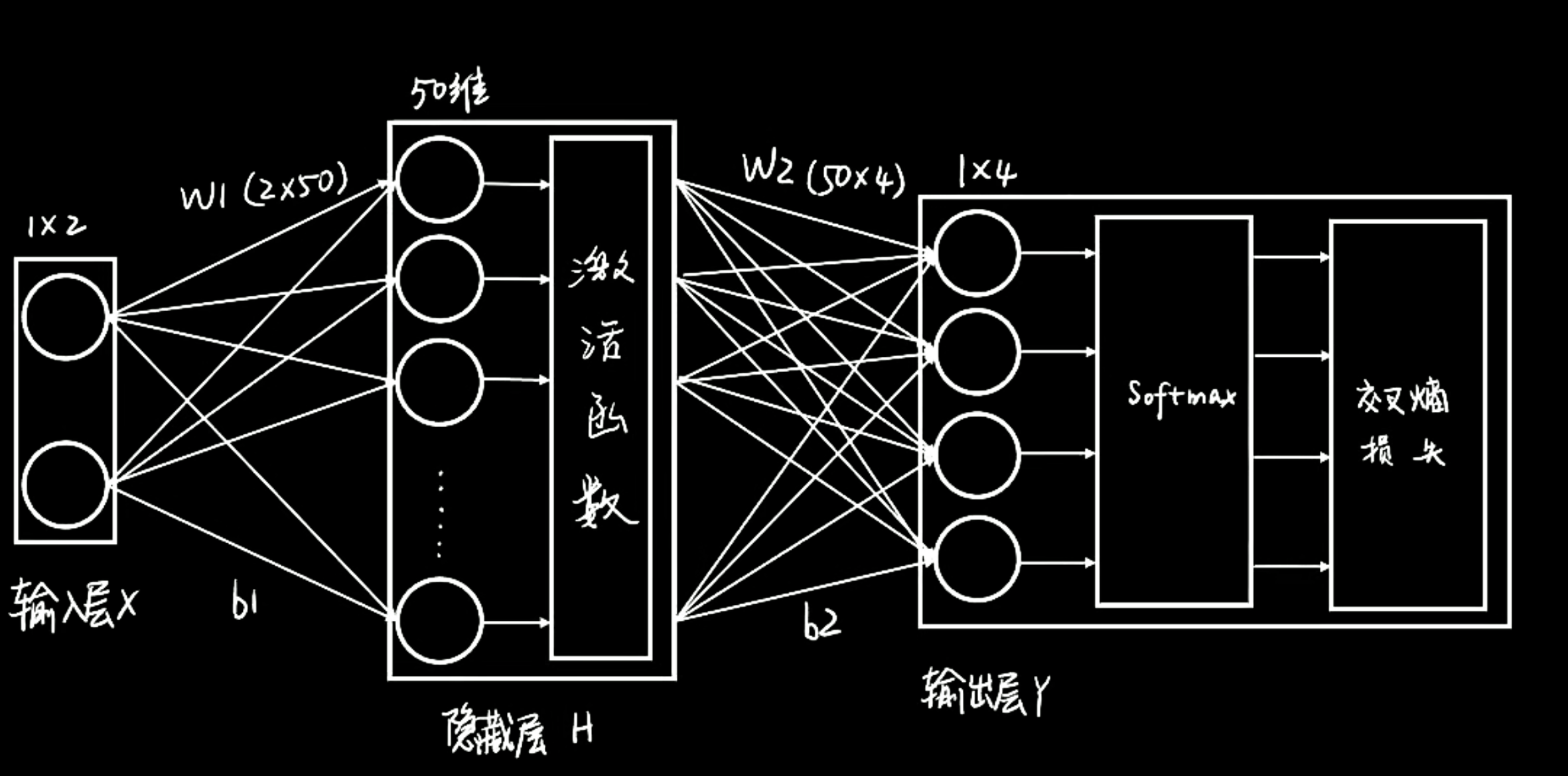

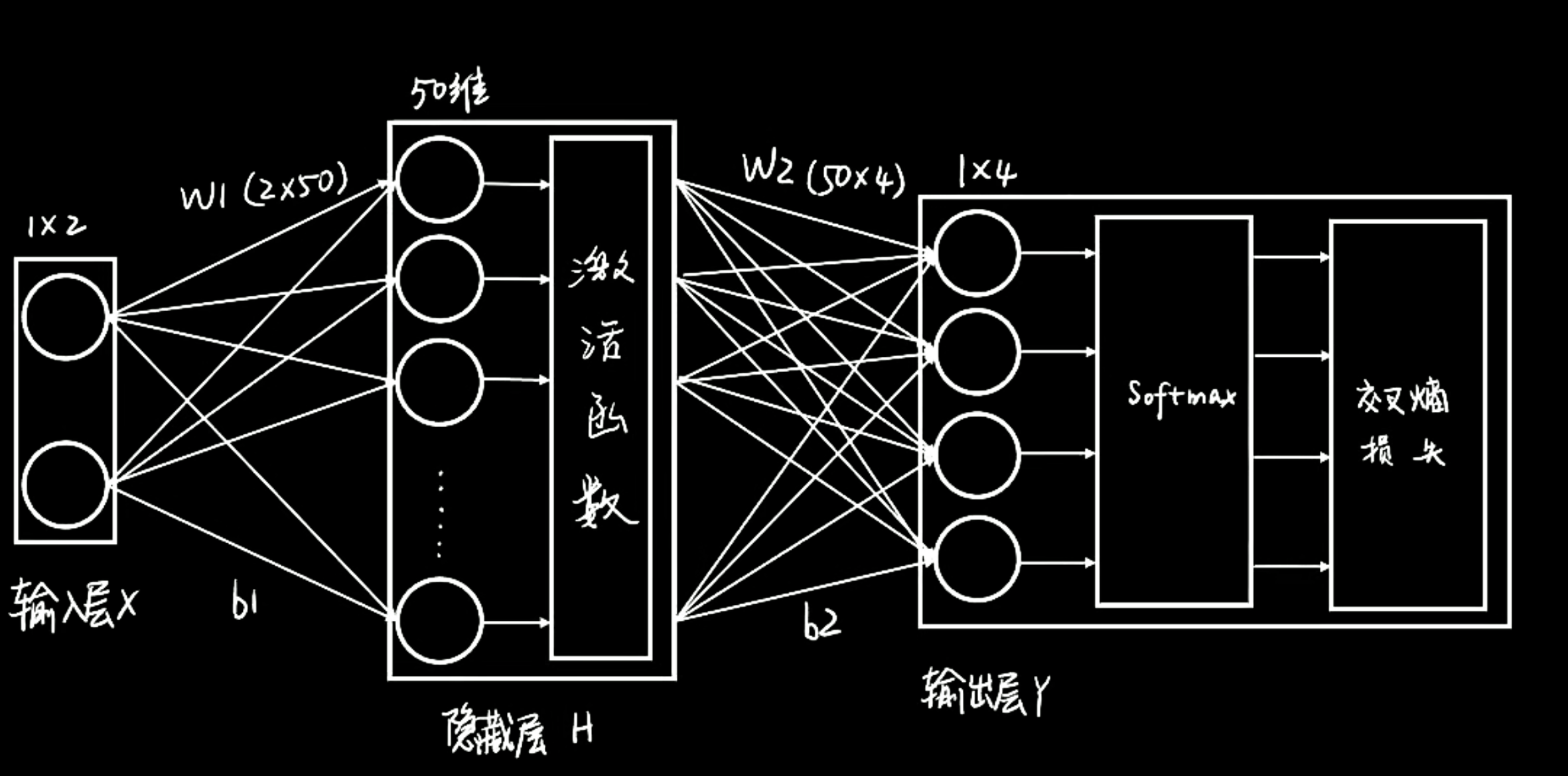

输入层 到 隐藏层H 到 输出层

隐藏层虽然一般较多层,但是一般不能过多,否则容易过拟合.

神经网络曾经叫做多层感知机(MLP),是一种基于人工神经网络的机器学习算法。

但是就算一百层神经网络线性组合,最后还是可以只用一个线性方程组表示,所以这种就退化了. 我们加入激活函数注入灵魂!

常见激活函数层

阶跃函数:

f(x)={0,1,x<0x≥0

Sigmoid函数:

f(x)=1+e−x1

tanh函数:

f(x)=ex+e−xex−e−x

ReLU函数:(目前最常用的激活函数)

f(x)=max(0,x)

Softmax层

Softmax层的作用是将神经网络的输出转换成概率分布,使得输出的每一维对应一个类别的概率。

Softmax层的公式为:

softmax(xi)=∑jexp(xj)exp(xi)

然后,−log(softmax(xi)) 来衡量模型对样本xi的预测的准确性,这个值越小说明模型的预测越准确。

然后对softmax结果计算交叉熵损失.交叉熵越小,说明模型的预测越准确.

损失函数: 交叉熵损失

从输入层到输出层的隐藏层在几何上的解释:看作是升维/平移/旋转/缩放,直线也变得扭曲,最后拟合为分界的函数